monqInstallDoc

Введение

Цель данной инструкции предоставить пользователю возможность самостоятельно выполнить установку Monq включая все компоненты инфраструктуры в требуемой конфигурации.

Инструкция описывает предполагаемый путь по развертыванию системы и носит рекомендательный характер, каждая установка уникальна по своему, частные утвержденные особенности операционной системы, отдельные наборы прав и ограничений.

Документ предполагает развертывания системы на базовых образах операционных систем без дополнительных изменений.

Для администрирования Monq и работы с данным документом пользователю нужно иметь опыт по работе с:

- инструментарием запуска контейнеров: containerd, docker

- оркестратором: kubernetes, в частности понимать как работать с логами

- субд: postgresql, clickhouse, redis, arangodb, victoriametrics

- брокером сообщений: rabbitmq

- кеш сервером: redis

- веб сервером: nginx

- сертификатами ssl

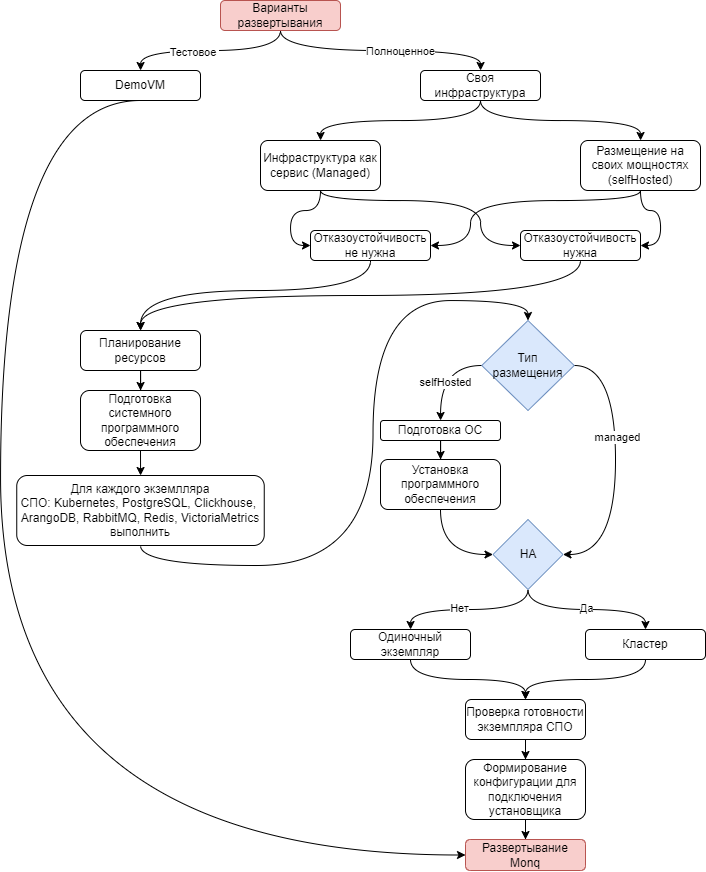

Схематический план развертывания Monq

Проектирование решения

Перед началом планирования ресурсов для запуска Monq необходимо ознакомиться с общими требованиями и рекомендациями для запуска системы.

Список необходимых компонентов:

| Название | Версия |

|---|---|

| postgresql | 16.6 |

| victoria-metrics | 1.108.1 |

| arangodb | 3.11.12 |

| redis | 7.4.2 |

| rabbitmq | 4.0.5 |

| clickhouse | 24.8.11 |

| consul | 1.8.0 |

| kubernetes | 1.31.4 |

| nginx-ingress-controller | 1.12.1 |

| container registry* | - |

| CSI совместимый storage (с поддержкой RWX)** | - |

* container registry должен быть совместим образами в docker формате

** Требуется наличие RWX(readWriteMany) хранилища, для подключения в несколько сервисов (реплик). Список совместимых решений можно посмотреть в официальной документации.

Рекомендации:

- Для построения дисковой системы рекомендуется использовать SSD диски.

- Весь объем диска должен быть смонтирован в

/. - Использование файловых систем

ext4илиxfs. - Не требуется установка Desktop Environment.

- Процессор с поддержкой SSE 4.2 и AVX2.

Данное руководство не учитывает расход ресурсов операционной системы и дополнительных служб(агентов мониторинга, резервного копирования и т.д.). Для наиболее точного планирования ресурсов необходимо понимание нагрузки и требований к отказоустойчивости выбранного решения.

Типовые схемы размещения компонентов

В разделе представлены наиболее распространенные конфигурации установки системы. Указанные системные требования рассчитаны на основе пользовательского опыта и могут отличаться в зависимости от характера или интенсивности нагрузки.

Demo образ

Одна Виртуальная машина (далее ВМ) с предустановленной инфраструктурой. Все микросервисы запущены в единственном экземпляре, системное программное обеспечение сконфигурировано на минимальное использование ресурсов.

Внимание! Образ ВМ предоставляется в ознакомительных целях, для возможности наиболее быстрой установки системы. Данное решение не поддерживает горизонтальное масштабирование.

Минимальные ресурсы:

| VM | CPU | RAM | Disk |

|---|---|---|---|

| Demo-VM | 8 | 24 | 60 |

Для выполнения установки необходимо скачать образ ВМ с официального сайта по ссылке https://monq.ru/download, и выполнить установку Monq согласно инструкции.

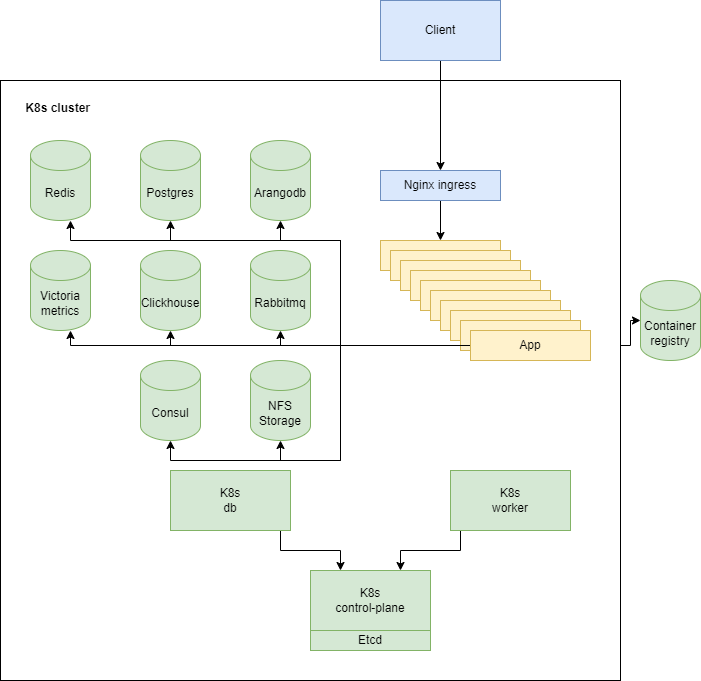

Минимальная конфигурация

Минимально три сервера(ВМ), ручная подготовка инфраструктуры. Данная конфигурация позволит горизонтально масштабировать инфраструктуру при увеличении нагрузки путем добавления новых нод в kubernetes и перераспределения нагрузки, но не обеспечит отказоустойчивость решения. Все машины являются нодами kubernetes, СУБД запущены с помощью statefulSet.

Минимальные ресурсы:

| Сервер(VM) | Hostname | CPU | RAM | Disk |

|---|---|---|---|---|

| Kubernetes control-plane | master | 2 | 4 | 30 |

| Kubernetes worker | worker | 8 | 24 | 80 |

| Kubernetes database | db | 8 | 14 | 200 |

Внимание! Hostname серверов указаны для примера, и будут использованы далее в пошаговой инструкции. Ограничений на Hostname нет, но изменения следует учитывать при выполнении команд.

Схема расположения компонентов представлена на рисунке:

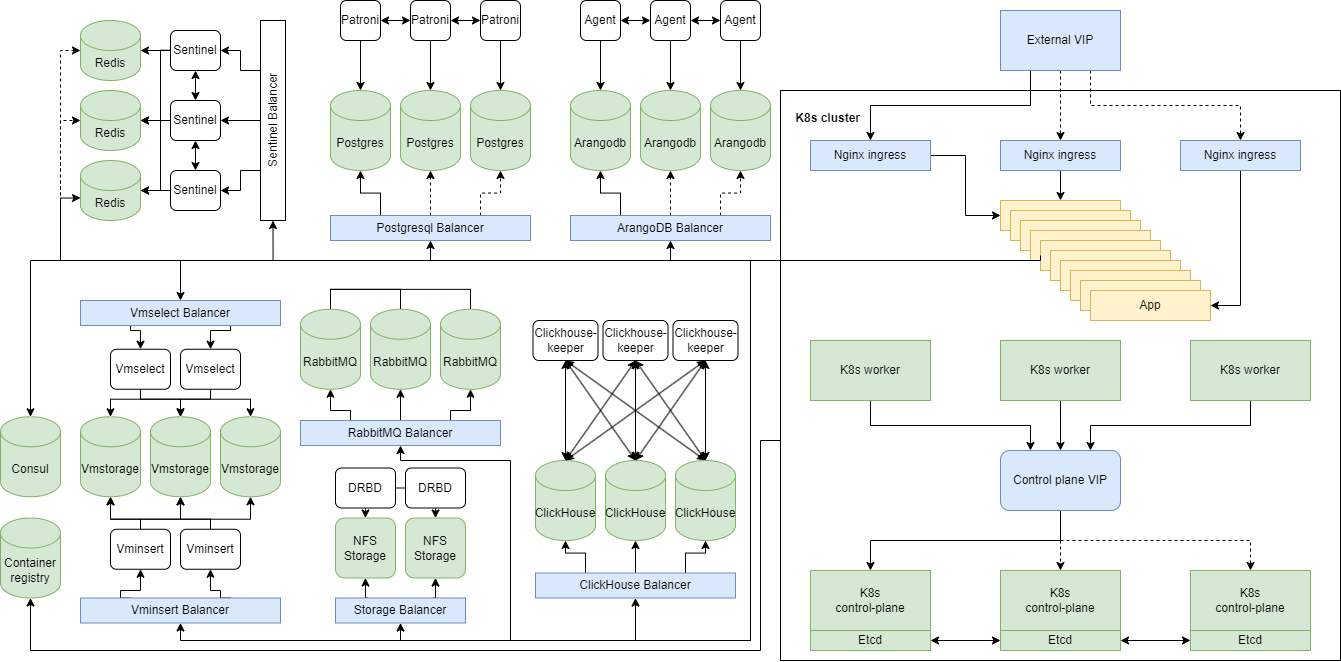

Отказоустойчивая конфигурация

Все компоненты СПО запускаются в режиме отказоустойчивом режиме (далее HA), имеется возможность масштабирования количества микросервисов, участвующих в обработке данных. СУБД запущены в kubernetes с помощью операторов.

| VM | Hostname | CPU | RAM | Disk |

|---|---|---|---|---|

| Kubernetes control-plane | master-1 | 2 | 4 | 30 |

| Kubernetes control-plane | master-2 | 2 | 4 | 30 |

| Kubernetes control-plane | master-3 | 2 | 4 | 30 |

| Kubernetes worker | worker-1 | 12 | 24 | 120 |

| Kubernetes worker | worker-2 | 12 | 24 | 120 |

| Kubernetes worker | worker-3 | 12 | 24 | 120 |

| ArangoDB | arangodb-1 | 8 | 32 | 60 |

| ArangoDB | arangodb-2 | 8 | 32 | 60 |

| ArangoDB | arangodb-3 | 8 | 32 | 60 |

| Clickhouse | clickhouse-1 | 8 | 24 | 400 |

| Clickhouse | clickhouse-2 | 8 | 24 | 400 |

| Clickhouse | clickhouse-3 | 8 | 24 | 400 |

| Postgresql | postgresql-1 | 6 | 16 | 200 |

| Postgresql | postgresql-2 | 6 | 16 | 200 |

| Postgresql | postgresql-3 | 6 | 16 | 200 |

| RabbitMQ | rabbitmq-1 | 4 | 6 | 60 |

| RabbitMQ | rabbitmq-2 | 4 | 6 | 60 |

| RabbitMQ | rabbitmq-3 | 4 | 6 | 60 |

| Redis | redis-1 | 4 | 6 | 40 |

| Redis | redis-2 | 4 | 6 | 40 |

| Redis | redis-3 | 4 | 6 | 40 |

| VictoriaMetrics | vm-1 | 8 | 16 | 300 |

| VictoriaMetrics | vm-2 | 8 | 16 | 300 |

| VictoriaMetrics | vm-3 | 8 | 16 | 300 |

Внимание! Hostname серверов указаны для примера, и будут использованы далее в пошаговой инструкции. Ограничений на Hostname нет, но изменения следует учитывать при выполнении команд.

Схема расположения компонентов представлена на рисунке:

Использование Managed сервисов

Приведенные выше решения подразумевают ручную установку СПО совместно с Monq. Со стороны Monq нет явных ограничений, в каком виде они будут развернуты - это может быть установка "на железе", в виде отдельного контейнера или внутри кластера Kubernetes с помощью оператора. Главное чтобы все точки подключения к компонентам СПО были доступны из кластера. Возможно использование Managed сервисов (корпоративных или предоставляемых облачными провайдерами) удовлетворяющих минимальным требованиям для следующих компонентов СПО:

- Kubernetes ‐ возможность создания service account k8s с правами на добавление/просмотр/удаление всех сущностей в namespace через API.

- PostgreSQL - возможность создания роли обладающей привилегиями:

- создание/удаление БД;

- создание/удаление пользователей;

- назначение владельцев для созданных БД;

- назначение прав для пользователей в БД.

- Clickhouse - возможность создания пользователя обладающего привилегиями:

- назначение пользователю прав

access_management; - создание/удаление БД;

- создание/удаление пользователей;

- назначение прав для пользователей в БД.

- назначение пользователю прав

- ArangoDB - возможность создания пользователя обладающего привилегиями:

- создание/удаление БД;

- создание/удаление пользователей;

- назначение прав для пользователей в БД.

- RabbitMQ - возможность создания пользователя обладающего привилегиями:

- создание/удаление пользователей;

- назначение ролей пользователям;

- назначение прав для пользователей в очередях.

- Redis

- доступ к базам данных DB 0-4;

- VictoriaMetrics

- возможность чтения/записи в БД.

Перед выбором managed сервиса для использования следует удостовериться в соответствии вышеуказанным требованиям.

Отказоустойчивость и балансировка нагрузки

В текущей реализации Monq нет встроенной поддержки работы с СПО в режимах балансировки нагрузки. Для каждого из компонентов определение работоспособности и балансировка запросов к работоспособному экземпляру осуществляется сторонними средствами (например Kubernetes service или HA-Proxy), за исключением Redis, для которого реализован механизм обнаружения ведущего сервера с помощью sentinel.

Monq поддерживает работу в режиме высокой доступности со следующими компонентами СПО:

- Kubernetes - master-master;

- PostgreSQL - master-slave;

- Clickhouse - master-master;

- ArangoDB - active-failover (master-slave);

- RabbitMQ - master-master;

- Redis - master-slave;

- VictoriaMetrics - master-master.

Пример запуска Monq с СПО в режиме HA будет рассмотрен более подробно в приложениях к документации по развертыванию.

Кластеризация

Под кластеризацией или шардированием понимается частичное разнесение информации между компонентами СПО.

В настоящий момент Monq не поддерживает кластеризацию данных, при проектировании решения это необходимо учитывать.

Заключение

На этапе проектирования решения следует выбрать способ развертывания того или иного компонента:

- тип инсталляции: пробная, минимальная конфигурация, отказоустойчивая конфигурация или спроектированная самостоятельно в зависимости от требований;

- Self-Hosted или Managed;

- HA или Standalone.

Выбранная архитектура решения может быть изменена и в процессе эксплуатации, но потребует проведения большого количества ручных операций.

Подготовка системного программного обеспечения

В соответствии с проектированием решения и планированием ресурсов потребуется подготовить итоговый стенд для развертывания. В данном разделе будет представлена пошаговая инструкция по подготовке минимального контура для запуска monq, которая подразумевает использование следующего набора ПО:

| Название | Версия | Роль | Лицензия |

|---|---|---|---|

| debian | 12.9 | Операционная система | GNU GPL |

| containerd | 1.7.25 | Среда для запуска контейнеров | Apache License 2.0 |

| postgresql | 16.6 | Субд | PostgreSQL |

| victoria-metrics | 1.108.1 | Субд | Apache License 2.0 |

| arangodb | 3.11.12 | Субд | Apache License 2.0 |

| redis | 7.4.2 | Кеш сервер | 3-Clause-BSD |

| rabbitmq | 4.0.5 | Брокер сообщений | Mozilla Public License |

| clickhouse | 24.8.11 | Субд | Apache License 2.0 |

| cilium | 1.16.5 | Плагин сети | Apache License 2.0 |

| consul | 1.8.0 | Хранилище конфигураций | Mozilla Public License v2.0 |

| kubernetes | 1.31.4 | Оркестратор контейнеров | Apache License 2.0 |

| nginx-ingress-controller | 1.12.1 | Веб балансировщик | Apache License 2.0 |

| registry | 2.8.3 | Репозиторий контейнеров | Apache License 2.0 |

Для запуска на дистрибутивах отличных от Debian 12.9 потребуется адаптировать команды приведенные в пошаговой инструкции.

По тексту будут ссылки на работу с файлом authfile, в целях исключения многократного повторения ссылка размещена в начале документа: см. Приложение. Инструкция по наполнению authfile.

При использовании managed сервисов следует заполнить данные authfile и пропустить блоки инструкции описывающие установку данного сервиса.

Предпочтительный способ обращения микросервисов Monq к компонентам СПО c использованием доменных имен, без указания

IP адресов. Перед началом работ следует выбрать доменные имена для компонентов СПО. В пошаговой инструкции будет

использована зона in.monq.local. Каждому компоненту СПО присваивается отдельное доменное имя, например

postgresql.in.monq.local. Для интерфейса monq так же необходимо быбрать доменное имя(${global_domain} далее).

Рекомендуется использование внутреннего корпоративного DNS сервера для разрешения доменных

имен компонентов СПО, перед тем как приступить к установке необходимо добавить соответствующие записи:

| № | Сервис, назначение | Доменное имя по умолчанию | Расположение |

|---|---|---|---|

| 1 | Репозиторий контейнеров | registry.in.monq.local | db |

| 2 | СУБД postgresql* | postgresql.in.monq.local | db |

| 3 | СУБД clickhouse* | clickhouse.in.monq.local | db |

| 4 | СУБД arangodb* | arangodb.in.monq.local | db |

| 5.a | СУБД victoriametrics single | victoriametrics.in.monq.local | db |

| 5.b | СУБД victoriametrics, кластер | vminsert.in.monq.local | db |

vmselect.in.monq.local | db | ||

| 6 | Кеш сервер, Redis** | redis.in.monq.local | db |

| 7 | Брокер сообщений, Rabbitmq* | rabbitmq.in.monq.local | db |

| 8 | Адрес API сервера k8s* | k8s-api.in.monq.local | master |

| 9 | Адрес хранилища конфигураций | consul.in.monq.local | db |

| 10 | Доменные имена установки monq, | ${global_domain} | worker |

| разрешаются в адрес ingress контроллера, | api.${global_domain} | worker | |

| при HA в Loadbalancer | registry.api.${global_domain} | worker |

Таблица также отражает расположение компонентов по серверам, которое будет использовано в руководстве по установке.

* в случае использования HA, указать адрес балансировщика запросов;

** в случае использования HA, указать адрес sentinel.

Указанные доменные имена задействованы в установке и эксплуатации системы и должны корректно разрешаться внутри kubernetes, а так же с машины на которой будет производиться запуск сценария установки Monq.

В случае если нет возможности использовать корпоративный DNS, необходимо добавить вышеуказанные записи в hosts на каждом хосте до начала установки и выполнить настройку разрешения доменных имен на кластерном coredns в составе kubernetes после его инициализации, см. Приложение. Кластерный DNS.

В пошаговой инструкции отражен способ запуска СУБД с помощью StatefulSet Kubernetes. Для хранения данных используются hostPath volumes. Данное решение не рекомендовано к запуску в промышленной эксплуатации. Вместо этого необходимо использовать CSI совместимый RWO storage. Список совместимых решений можно посмотреть в официальной документации.

Список переменных, используемых по тексту:

${infra_domain}- dns зона для инфраструктурных компонентов${global_domain}- основное доменное имя развертываемого приложения${registry_address}- адрес репозитория контейнеров${infra_namespace}- kubernetes namespace для запуска инфраструктурных компонентов${monq_namespace}- kubernetes namespace для запуска monq

Инструкция составлена с учетом выполнения команд от пользователя root, поэтому перед выполнением команд необходимо

перейти на использование root и установить переменные:

su -

infra_domain=in.monq.local

registry_address=registry.${infra_domain}:5000

infra_namespace=infra

monq_namespace=production

Платформа kubernetes

Установка ОС

При использовании kubernetes в "качестве сервиса", следует сразу перейти к пункту "Последующая настройка кластера".

Необходимо выполнить установку ос Debian 12.9 на все сервера/VM. Весь объем диска должен быть смонтирован в /,

файловая система ext4 или xfs. Раздел подкачки(swap) можно не создавать, тк он не будет использован. На этапе

выбора компонентов для установки следует выбрать стандартные системные утилиты и ssh сервер.

Выпуск CA сертификата

В данном разделе представлено руководство по выпуску самоподписного CA сертификата, который будет использован для шифрования соединений внутри системы.

Если планируется использовать существующие, заранее выпущенные, самоподписанные сертификаты, то необходимо обратиться к разделу Приложение. Собственные сертификаты SSL.

Данный CA сертификат будет использован для подписи сертификата используемого для организации защищенного соединения с web интерфейсом Monq, так же он может быть использован для выпуска сертификатов для создания защищенного соединения между компонентами Monq и СПО, см. Приложение. Описание типового helm chart. Для организации взаимодействия по SSL при развертывании в режиме HA необходимо обратиться к документации разработчика соответствующего решения.

Внимание! Команды выполняются на сервере master.

Сформировать CA сертификат:

mkdir certs

opensslConf=$(dpkg -L openssl | grep openssl.cnf | head -n 1)

openssl req -new -nodes -out certs/monq.ca.csr \

-keyout certs/monq.ca.key -subj "/CN=monq"

openssl x509 -req -in certs/monq.ca.csr -days 3650 \

-extfile ${opensslConf} -extensions v3_ca \

-signkey certs/monq.ca.key -out certs/monq.ca.crt

Добавить сертификат в список доверенных:

Внимание! Данный шаг нужно выполнить на всех серверах, предварительно скопировав файл

certs/monq.ca.crt

mkdir /usr/share/ca-certificates/monq

cp certs/monq.ca.crt /usr/share/ca-certificates/monq/monq.ca.crt

echo "monq/monq.ca.crt" >> /etc/ca-certificates.conf

update-ca-certificates

Выписать сертификат для registry:

mkdir certs/docker-registry

openssl req -new -nodes -out certs/docker-registry/registry.csr \

-keyout certs/docker-registry/registry.key -subj "/CN=registry.${infra_domain}"

openssl x509 -req -in certs/docker-registry/registry.csr -days 3650 \

-extfile <(printf "subjectAltName=DNS:registry.${infra_domain}") \

-CA certs/monq.ca.crt -CAkey certs/monq.ca.key -CAcreateserial \

-out certs/docker-registry/registry.crt

Файлы certs/docker-registry/registry.key и certs/docker-registry/registry.crt необходимо перенести на сервер db,

для последующей настройки container registry.

Установка пакетов

Внимание! Данный раздел написан для установки с доступом к сети Интернет. В случае если сервера не имеют доступа в интернет, необходимо заменить выполнение команд в данном разделе командами из Приложение. Установка пакетов Offline.

Внимание! Команды из данного раздела необходимо выполнить на всех серверах!

Выполнить установку пакетов:

apt update

apt install -y gpg curl dnsutils vim telnet unzip bash-completion ca-certificates jq \

nfs-common

Выполнить установку containerd:

mkdir -p /etc/apt/keyrings

curl -fsSL https://download.docker.com/linux/debian/gpg \

| gpg --dearmor -o /etc/apt/keyrings/docker.gpg

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] \

https://download.docker.com/linux/debian $(lsb_release -cs) stable" \

| tee /etc/apt/sources.list.d/docker.list > /dev/null

apt update

apt install containerd.io=1.7.25-1

Выполнить установку kubernetes:

curl -fsSL https://pkgs.k8s.io/core:/stable:/v1.31/deb/Release.key | \

gpg --dearmor -o /usr/share/keyrings/kubernetes-apt-keyring.gpg

echo "deb [signed-by=/usr/share/keyrings/kubernetes-apt-keyring.gpg] \

https://pkgs.k8s.io/core:/stable:/v1.31/deb/ /" \

| tee /etc/apt/sources.list.d/kubernetes.list

apt update

apt install -y kubelet=1.31.4-1.1 kubeadm=1.31.4-1.1 kubectl=1.31.4-1.1

apt-mark hold kubelet kubeadm kubectl

Выполнить установку helm:

wget https://get.helm.sh/helm-v3.17.0-linux-amd64.tar.gz

tar -xf helm-v3.17.0-linux-amd64.tar.gz linux-amd64/helm

mv linux-amd64/helm /usr/local/bin/

rm -r helm-v3.17.0-linux-amd64.tar.gz linux-amd64/

Выполнить установку discli:

wget "https://github.com/shdubna/discli/releases/download\

/v0.1.2/discli_Linux_x86_64.tar.gz"

tar -xf discli_Linux_x86_64.tar.gz -C /usr/local/bin/ discli

rm discli_Linux_x86_64.tar.gz

Установка Container registry

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста registry вида registry.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен container registry (в данном примере сервер db).

Внимание! Команды выполняются на сервере db.

Выполнить установку container registry:

wget "https://github.com/distribution/distribution\

/releases/download/v2.8.3/registry_2.8.3_linux_amd64.tar.gz"

tar -xf registry_2.8.3_linux_amd64.tar.gz -C /usr/local/bin/ registry

rm registry_2.8.3_linux_amd64.tar.gz

Создать пользователя для registry:

useradd --no-create-home --shell /bin/false registry

Создать каталоги для работы приложения:

mkdir -p /storage/registry

chown -R registry /storage/registry

mkdir -p /etc/docker/registry

Сформировать конфигурационный файл:

cat <<EOF | tee /etc/docker/registry/config.yaml

version: 0.1

log:

fields:

service: registry

storage:

cache:

blobdescriptor: inmemory

filesystem:

rootdirectory: /storage/registry

delete:

enabled: true

http:

addr: :5000

tls:

certificate: /etc/docker/registry/registry.crt

key: /etc/docker/registry/registry.key

headers:

X-Content-Type-Options: [nosniff]

health:

storagedriver:

enabled: true

interval: 10s

threshold: 3

EOF

Создать unit для systemd:

cat <<EOF | tee /etc/systemd/system/registry.service

[Unit]

Description=docker private registry service

[Service]

ExecStart=/usr/local/bin/registry serve /etc/docker/registry/config.yaml

Restart=always

Type=simple

RestartSec=10s

User=registry

[Install]

WantedBy=multi-user.target

EOF

Скопировать сертификат registry выпущенный ранее на шаге Выпуск CA сертификата:

cp certs/docker-registry/registry.key certs/docker-registry/registry.crt /etc/docker/registry

chown -R registry /etc/docker/registry

Выполнить запуск container registry:

systemctl start registry

systemctl enable registry

Для наполнения authfile выставить значения:

- registry.host:

"registry.in.monq.local" - registry.port:

5000 - registry.proto:

"https" - registry.auth_type:

"None"

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

Установка сервера NFS

Внимание! Команды выполняются на сервере db.

Выполнить установку nfs-server:

apt install -y nfs-kernel-server

host_path="/storage/nfs"

mkdir -p $host_path

echo "$host_path *(rw,sync,no_root_squash,no_all_squash,no_subtree_check)" >> \

/etc/exports

systemctl restart nfs-server

systemctl enable nfs-server

Создание каталогов для хранения данных СУБД

Внимание! Команды выполняются на сервере db, согласно таблице размещения компонентов.

Создать каталоги для хранения данных компонентов СПО:

mkdir -p /storage/consul

mkdir -p /storage/arangodb

mkdir -p /storage/clickhouse

mkdir -p /storage/postgresql

mkdir -p /storage/rabbitmq

mkdir -p /storage/redis

mkdir -p /storage/victoriametrics

Импорт контейнеров СПО

Внимание! Команды выполняются одном из серверов где был установлен discli.

Выполнить импорт образов контейнеров платформы kubernetes в container registry:

discli copy registry.k8s.io/coredns/coredns:v1.11.3 ${registry_address}/coredns:v1.11.3

discli copy registry.k8s.io/kube-proxy:v1.31.4 ${registry_address}/kube-proxy:v1.31.4

discli copy registry.k8s.io/pause:3.10 ${registry_address}/pause:3.10

discli copy registry.k8s.io/kube-apiserver:v1.31.4 \

${registry_address}/kube-apiserver:v1.31.4

discli copy registry.k8s.io/kube-controller-manager:v1.31.4 \

${registry_address}/kube-controller-manager:v1.31.4

discli copy registry.k8s.io/kube-scheduler:v1.31.4 \

${registry_address}/kube-scheduler:v1.31.4

discli copy registry.k8s.io/etcd:3.5.15-0 ${registry_address}/etcd:3.5.15-0

discli copy quay.io/cilium/cilium:v1.16.5 ${registry_address}/cilium/cilium:v1.16.5

discli copy quay.io/cilium/operator-generic:v1.16.5 \

${registry_address}/cilium/operator-generic:v1.16.5

discli copy registry.k8s.io/ingress-nginx/controller:v1.12.1 \

${registry_address}/ingress-nginx/controller:v1.12.1

discli copy registry.k8s.io/ingress-nginx/kube-webhook-certgen:v1.5.2 \

${registry_address}/ingress-nginx/kube-webhook-certgen:v1.5.2

discli copy consul:1.8.0 ${registry_address}/consul:1.8.0

Выполнить импорт образов контейнеров используемого СПО в container registry:

discli copy arangodb:3.11.12 ${registry_address}/arangodb:3.11.12

discli copy clickhouse/clickhouse-server:24.8.11 \

${registry_address}/clickhouse/clickhouse-server:24.8.11

discli copy postgres:16.6 ${registry_address}/postgres:16.6

discli copy rabbitmq:4.0.5-management ${registry_address}/rabbitmq:4.0.5-management

discli copy redis:7.4.2 ${registry_address}/redis:7.4.2

discli copy victoriametrics/victoria-metrics:v1.108.1 \

${registry_address}/victoriametrics/victoria-metrics:v1.108.1

В случае если планируется HA инсталляция, импортировать дополнительные образы:

discli copy ghcr.io/kube-vip/kube-vip:v0.8.9 ${registry_address}/kube-vip/kube-vip:v0.8.9

discli copy ghcr.io/zalando/postgres-operator:v1.14.0 \

${registry_address}/zalando/postgres-operator:v1.14.0

discli copy ghcr.io/zalando/spilo-17:4.0-p2 ${registry_address}/zalando/spilo-17:4.0-p2

discli copy altinity/clickhouse-operator:0.24.2 \

${registry_address}/altinity/clickhouse-operator:0.24.2

discli copy clickhouse/clickhouse-keeper:24.8.11 \

${registry_address}/clickhouse/clickhouse-keeper:24.8.11

discli copy arangodb/kube-arangodb:1.2.41 ${registry_address}/arangodb/kube-arangodb:1.2.41

discli copy victoriametrics/operator:v0.52.0 \

${registry_address}/victoriametrics/operator:v0.52.0

discli copy victoriametrics/vminsert:v1.108.1-cluster \

${registry_address}/victoriametrics/vminsert:v1.108.1-cluster

discli copy victoriametrics/vmselect:v1.108.1-cluster \

${registry_address}/victoriametrics/vmselect:v1.108.1-cluster

discli copy victoriametrics/vmstorage:v1.108.1-cluster \

${registry_address}/victoriametrics/vmstorage:v1.108.1-cluster

discli copy quay.io/spotahome/redis-operator:v1.2.4 \

${registry_address}/spotahome/redis-operator:v1.2.4

discli copy rabbitmqoperator/cluster-operator:2.12.1 \

${registry_address}/rabbitmqoperator/cluster-operator:2.12.1

Загрузка helm chart

Внимание! Команды выполняются на сервере master.

Скачать чарты:

mkdir -p offline/charts/

helm repo add cilium https://helm.cilium.io/

helm pull cilium/cilium --version 1.16.5 -d offline/charts/

helm repo add ingress-nginx https://kubernetes.github.io/ingress-nginx

helm pull ingress-nginx/ingress-nginx --version 4.12.1 -d offline/charts/

helm repo add monq https://helm.monq.ru/charts

helm pull monq/postgresql --version 1.1.0 -d offline/charts/

helm pull monq/clickhouse --version 1.1.0 -d offline/charts/

helm pull monq/arangodb --version 1.1.0 -d offline/charts/

helm pull monq/victoriametrics --version 1.1.0 -d offline/charts/

helm pull monq/redis --version 1.1.0 -d offline/charts/

helm pull monq/rabbitmq --version 1.1.0 -d offline/charts/

helm pull monq/consul --version 1.0.1 -d offline/charts/

В случае если планируется HA инсталляция, скачать дополнительные чарты:

helm repo add postgres-operator-charts \

https://opensource.zalando.com/postgres-operator/charts/postgres-operator

helm pull postgres-operator-charts/postgres-operator --version 1.14.0 -d offline/charts/

helm repo add clickhouse-operator https://docs.altinity.com/clickhouse-operator/

helm pull clickhouse-operator/altinity-clickhouse-operator \

--version 0.24.2 -d offline/charts/

url="https://github.com/arangodb/kube-arangodb/releases/download/1.2.41"

helm pull ${url}/kube-arangodb-1.2.41.tgz -d offline/charts/

helm repo add vm https://victoriametrics.github.io/helm-charts/

helm pull vm/victoria-metrics-operator --version 0.41.0 -d offline/charts/

helm repo add redis-operator https://spotahome.github.io/redis-operator

helm pull redis-operator/redis-operator --version 3.2.9 -d offline/charts/

wget "https://github.com/rabbitmq/cluster-operator\

/releases/download/v2.12.1/cluster-operator.yml" -P offline/charts

Установка monqctl и импорт контейнеров ППО

Внимание! Команды выполняются на сервере master.

Выполнить установку monqctl:

wget https://downloads.monq.ru/tools/monqctl/v1.16.1/linux-x64/monqctl.zip

unzip monqctl.zip

mv monqctl /usr/local/bin

rm monqctl.zip

Выполнить временную конфигурацию контекста monqctl:

token="< токен обновления полученный с сайта. выписывается вместе с лицензией >"

monqctl config set instance temp --server=http://registry.api.monq.local

monqctl config set credential temp --registry-token=000

monqctl config set releasehub monq-release-hub --token=${token}

monqctl config set context temp --instance=temp --credential=temp \

--releasehub=monq-release-hub

monqctl config use-context temp

Выполнить импорт образов контейнеров Monq в container registry:

monqctl release use-version 8.9.0 --product=installer

monqctl release import-images --registryUri ${registry_address} --registryAuth=None

monqctl release use-version 3.16.0 --product=monq-registry

monqctl release import-images --registryUri ${registry_address} --registryAuth=None

monqctl release use-version 8.9.0 --product=monq

monqctl release import-images --registryUri ${registry_address} --registryAuth=None

Выполнить удаление временной конфигурации monqctl:

rm ~/.monq/config.yml

rm -rf /tmp/monqctl

Инициализация Control Plane

Дополнительные варианты развертывания:

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста master вида

k8s-api.${infra_domain}, запись должна разрешаться в IP master сервера.

Внимание! Команды выполняются на сервере master.

Внимание! Если не было настроено разрешение доменных имен на вышестоящем DNS сервере, то добавить запись с указанием доменного имени и ip адреса сервера хостинга k8s control-plane в /etc/hosts.

Задать нужное имя сервера, в примере используется master (имя сервера должно корректно разрешаться в ip адрес сервера):

hostnamectl set-hostname master

Выполнить настройку синхронизации времени, и убедиться что время синхронизировано:

timedatectl status

В случае если необходимо изменить адреса NTP серверов надо отредактировать файл и выполнить перезапуск сервиса:

nano /etc/systemd/timesyncd.conf

systemctl enable systemd-timesyncd

systemctl restart systemd-timesyncd

Отключить swap:

swapoff -a

sed -i '/ swap / s/^/#/' /etc/fstab

Загрузить необходимые модули ядра:

cat <<EOF | tee /etc/modules-load.d/containerd.conf

overlay

br_netfilter

EOF

modprobe br_netfilter

modprobe overlay

Добавить опции ядра:

cat <<EOF | tee /etc/sysctl.d/99-kubernetes-cri.conf

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

fs.inotify.max_user_instances = 524288

EOF

cat <<EOF | tee /etc/sysctl.d/70-disable-ipv6.conf

net.ipv6.conf.all.disable_ipv6 = 1

EOF

sysctl --system

Выполнить конфигурацию containerd:

containerd config default | sed "

s|SystemdCgroup = false|SystemdCgroup = true|g

s|\(.*sandbox_image = \)\".*/pause:.*\"|\1\"${registry_address}/pause:3.10\"|g

" > /etc/containerd/config.toml

systemctl enable containerd

systemctl restart containerd

Настроить автодополнение команд:

mkdir -p /etc/bash_completion.d/

kubectl completion bash > /etc/bash_completion.d/kubectl

crictl completion bash > /etc/bash_completion.d/crictl

helm completion bash > /etc/bash_completion.d/helm

cat > /etc/crictl.yaml << EOF

runtime-endpoint: unix:///run/containerd/containerd.sock

image-endpoint: unix:///run/containerd/containerd.sock

timeout: 2

debug: false

pull-image-on-create: true

EOF

Активировать автодополнение команд для текущего пользователя:

cat >> ~/.bashrc << EOF

if [ -f /etc/bash_completion ] && ! shopt -oq posix; then

. /etc/bash_completion

fi

EOF

Провести инициализацию control plane:

k8s_domain="k8s-api.${infra_domain}"

systemctl enable kubelet.service

kubeadm init --control-plane-endpoint "${k8s_domain}:6443" \

--skip-phases="addon/kube-proxy" \

--upload-certs \

--pod-network-cidr="10.244.0.0/16" \

--service-cidr="10.16.0.0/16" \

--image-repository="${registry_address}" \

--kubernetes-version 1.31.4

В случае если сети pod и service пересекаются с текущими сетями есть возможность задать другие сети, рекомендуется использовать /16.

По завершении команды будет выдано сообщение с командой которую необходимо выполнить на остальных серверах для join, ее следует скопировать для дальнейшего использования.

Выполнить конфигурацию kubectl:

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config

Выполнить настройки опций логирования:

kubectl get cm -n kube-system kubelet-config -o json | sed '

s|cluster.local\\n|cluster.local\\ncontainerLogMaxFiles: 2\\n|g

s|cluster.local\\n|cluster.local\\ncontainerLogMaxSize: 10Mi\\n|g

' | kubectl replace -f -

echo "containerLogMaxFiles: 2" >> /var/lib/kubelet/config.yaml

echo "containerLogMaxSize: 10Mi" >> /var/lib/kubelet/config.yaml

systemctl restart kubelet

В данном примере используется cilium в режиме kube-proxy replacement (kubernetes инициализирован без kube-proxy). Использование других CNI возможно, но не описывается в данной документации. При использовании других CNI следует изменить команду инициализации для запуска kube-proxy.

Выполнить установку cilium:

api_server_host="k8s-api.${infra_domain}"

api_server_port="6443"

helm upgrade --install cilium ./offline/charts/cilium-1.16.5.tgz \

--namespace kube-system \

--set kubeProxyReplacement=true \

--set k8sServiceHost=${api_server_host} \

--set k8sServicePort=${api_server_port} \

--set operator.replicas=1 \

--set ipam.mode=kubernetes \

--set image.useDigest=false \

--set image.repository="${registry_address}/cilium/cilium" \

--set operator.image.useDigest=false \

--set operator.image.repository="${registry_address}/cilium/operator" \

--set hubble.enabled=false \

--set l7Proxy=false

Убедиться что нода перешла в статуc Ready:

kubectl get node -w

Включение нод в kubernetes

Внимание! Команды выполняются на всех серверах worker/db

Внимание! Если не было настроено разрешение доменных имен на вышестоящем DNS сервере, то добавить запись с указанием доменного имени и ip адреса сервера хостинга k8s control-plane в /etc/hosts.

Задать нужное имя сервера, в примере используется worker:

hostnamectl set-hostname worker

Выполнить настройку синхронизации времени, и убедиться что время синхронизировано:

timedatectl status

В случае если необходимо изменить адреса NTP серверов надо отредактировать файл и выполнить перезапуск сервиса:

nano /etc/systemd/timesyncd.conf

systemctl enable systemd-timesyncd

systemctl restart systemd-timesyncd

Отключить swap:

swapoff -a

sed -i '/ swap / s/^/#/' /etc/fstab

Загрузить необходимые модули ядра:

cat <<EOF | tee /etc/modules-load.d/containerd.conf

overlay

br_netfilter

EOF

modprobe br_netfilter

modprobe overlay

Добавить опции ядра:

cat <<EOF | tee /etc/sysctl.d/99-kubernetes-cri.conf

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

fs.inotify.max_user_instances = 524288

EOF

cat <<EOF | tee /etc/sysctl.d/70-disable-ipv6.conf

net.ipv6.conf.all.disable_ipv6 = 1

EOF

sysctl --system

Выполнить конфигурацию containerd:

containerd config default | sed "

s|SystemdCgroup = false|SystemdCgroup = true|g

s|\(.*sandbox_image = \)\".*/pause:.*\"|\1\"${registry_address}/pause:3.10\"|g

" > /etc/containerd/config.toml

systemctl enable containerd

systemctl restart containerd

Настроить автодополнение команд:

mkdir -p /etc/bash_completion.d/

crictl completion bash > /etc/bash_completion.d/crictl

cat > /etc/crictl.yaml << EOF

runtime-endpoint: unix:///run/containerd/containerd.sock

image-endpoint: unix:///run/containerd/containerd.sock

timeout: 2

debug: false

pull-image-on-create: true

EOF

Импортировать CA сертификат выпущенный ранее на шаге Выпуск CA сертификата:

mkdir /usr/share/ca-certificates/monq

cp certs/monq.ca.crt /usr/share/ca-certificates/monq/monq.ca.crt

echo "monq/monq.ca.crt" >> /etc/ca-certificates.conf

update-ca-certificates

Внимание! Если не было настроено разрешение доменных имен на вышестоящем DNS сервере, то добавить запись с указанием доменного имени и ip адреса сервера хостинга k8s control-plane и container-registry в /etc/hosts.

systemctl enable kubelet

k8s_domain="k8s-api.${infra_domain}"

kubeadm join ${k8s_domain}:6443 --token ************* --discovery-token-ca-cert-hash \

sha256:*************

Если токен был утерян или срок действия истек, можно получить новый, для этого на master сервере надо выполнить команду:

kubeadm token create --print-join-command

Убедиться что ноды перешли в статус Ready, для этого на сервере k8s control-plane выполнить команду:

kubectl get node -w

В течении двух минут статус должен измениться.

Если нода так и не перешла в статус готовности, проверить логи kubelet.

Последующая настройка кластера

Внимание! Команды выполняются на сервере master.

Ingress controller

Nginx-ingress-controller отвечает за:

- маршрутизацию запросов от клиентов к микросервисам, в том числе для самих микросервисов при внутреннем взаимодействии;

- балансировку запросов между микросервисами, когда задействованы механизмы горизонтального масштабирования;

В данном примере балансировщик будет запущен в единственном экземпляре на ноде worker. В случае необходимости отказоустойчивого решения, метки необходимо добавить метки на все ноды планируемые для запуска ingress-nginx.

Добавить метку на ноду, для запуска ingress-nginx controller:

server_name=worker

kubectl label node ${server_name} ingress=

Запустить контроллер с помощью helm chart:

helm upgrade --install ingress-nginx offline/charts/ingress-nginx-4.12.1.tgz \

--namespace ingress-nginx --create-namespace \

--set controller.kind=DaemonSet \

--set controller.hostPort.enabled=true \

--set controller.nodeSelector.ingress="" \

--set controller.service.enabled=true \

--set controller.config.body-size=50m \

--set controller.config.hsts=false \

--set controller.config.large-client-header-buffers="4 32k" \

--set controller.config.proxy-body-size=50m \

--set controller.config.proxy-buffer-size=128k \

--set controller.config.proxy-buffers="4 256k" \

--set controller.config.proxy-busy-buffers-size=256k \

--set controller.config.proxy-connect-timeout="15" \

--set controller.config.proxy-read-timeout="300" \

--set controller.config.proxy-send-timeout="300" \

--set controller.config.server-name-hash-bucket-size="256" \

--set controller.config.worker-shutdown-timeout=10s \

--set controller.image.registry=${registry_address} \

--set controller.image.digest=null \

--set controller.admissionWebhooks.patch.image.registry=${registry_address} \

--set controller.admissionWebhooks.patch.image.digest=null

Проверить состояние контейнеров контроллера:

kubectl get po -n ingress-nginx -o wide -w

Пространства для запуска компонентов

Создать namespace для запуска инфраструктурных компонентов и Monq:

kubectl create namespace ${infra_namespace}

kubectl create namespace ${monq_namespace}

Ноды, предназначенные для запуска микросервисов Monq должны быть отмечены меткой "worker".

Внимание! Данную команду необходимо повторить для всех серверов с ролью worker.

kubectl label node worker function=worker

Задать лимиты по умолчанию для namespace production

Внимание! Не рекомендуется уменьшать лимиты по умолчанию.

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: LimitRange

metadata:

name: limit-range

namespace: ${monq_namespace}

spec:

limits:

- default:

cpu: 2

memory: 2048Mi

defaultRequest:

cpu: 25m

memory: 128Mi

type: Container

EOF

Создать secret содержащий CA сертификат выпущенный ранее в разделе Выпуск CA сертификата для его переиспользования в остальных компонентах:

kubectl create secret generic -n ${monq_namespace} monq-ca \

--from-file=./certs/monq.ca.key --from-file=./certs/monq.ca.crt

kubectl create secret generic -n ${monq_namespace} monq-ca-certificates \

--from-file=./certs/monq.ca.crt

Файловое хранилище

Требуется для хранения данных, которые по различным причинам не могут быть размещены в БД:

- вложения прикрепляемые к КЕ;

- артефакты проектов автотестирования;

- аватары в профиле пользователя;

- плагины системных агентов.

Используемый persistent volume должен поддерживать режим RWX (readWriteMany), так как может быть одновременно использован несколькими сервисами/репликами. Список совместимых решений можно посмотреть в официальной документации.

В данной инструкции будет рассмотрено решение на базе NFS, так как оно является самым распространенным.

Внимание! Если NFS предоставляется как сервис, то зафиксировать адрес подключения и перейти пункту создания PV и PVC.

Общий порядок установки и настройки:

В данном примере будет использован сервер db, на котором ранее был установлен NFS в разделе

Установка сервера NFS.

Создать PV и PVC:

host_path="/storage/nfs"

nfs_server_address="< ip address nfs server >"

nfs_storage_size="20Gi"

cat <<EOF | kubectl create -f -

apiVersion: v1

items:

- apiVersion: v1

kind: PersistentVolume

metadata:

name: pv-monq

annotations:

volume.beta.kubernetes.io/storage-class: nfs

spec:

capacity:

storage: ${nfs_storage_size}

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nfs:

server: "${nfs_server_address}"

path: "${host_path}"

- kind: PersistentVolumeClaim

apiVersion: v1

metadata:

name: pvc-monq

namespace: ${monq_namespace}

annotations:

volume.beta.kubernetes.io/storage-class: nfs

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: ${nfs_storage_size}

kind: List

metadata:

resourceVersion: ""

selfLink: ""

EOF

Авторизация в кластере kubernetes

Выписать и зафиксировать токен и адрес подключения к api k8s в authfile.

Применить манифесты сервисной учетной записи:

cat <<EOF | kubectl create -f -

apiVersion: v1

items:

- apiVersion: v1

kind: ServiceAccount

metadata:

name: "installer"

namespace: "${monq_namespace}"

secrets:

- name: "installer-token"

- apiVersion: v1

kind: Secret

metadata:

name: "installer-token"

namespace: "${monq_namespace}"

annotations:

kubernetes.io/service-account.name: "installer"

type: kubernetes.io/service-account-token

- apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: "installer"

namespace: "${monq_namespace}"

rules:

- apiGroups: [""]

resources: [ "services", "pods", "configmaps", "secrets", "serviceaccounts" ]

verbs: ['*']

- apiGroups: ['apps']

resources: [ "deployments" ]

verbs: ['*']

- apiGroups: [""]

resources: [ "namespaces", "persistentvolumeclaims" ]

verbs: ['get']

- apiGroups: ["networking.k8s.io"]

resources: [ "ingresses" ]

verbs: ['*']

- apiGroups: ["rbac.authorization.k8s.io"]

resources: [ "roles", "rolebindings" ]

verbs: ['*']

- apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: "installer"

namespace: "${monq_namespace}"

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: "installer"

subjects:

- kind: ServiceAccount

name: "installer"

namespace: "${monq_namespace}"

kind: List

metadata:

resourceVersion: ""

selfLink: ""

EOF

Получить токен:

installer_token=$(kubectl get secret -n ${monq_namespace} installer-token \

-o jsonpath='{.data.token}' | base64 --decode)

echo save it: ${installer_token}

Для наполнения authfile выставить значения:

- k8s.host:

"k8s-api.in.monq.local"; - k8s.port:

6443; - k8s.proto:

https; - k8s.users.root_user.token:

"<check ${installer_token}>";

Consul

Хранилище конфигураций Monq.

Рассматривается SelfHosted, запуск в единичном экземпляре statefulSet с помощью helm chart. Без высокой доступности.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста consul вида consul.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен consul(в данном примере сервер db).

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} consul=

Выполнить запуск с помощью helm chart:

helm install consul offline/charts/consul-1.0.1.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Инициализировать consul:

bootstrap_token=$(curl -s -X PUT consul.${infra_domain}:8500/v1/acl/bootstrap | jq -r '.ID')

echo "save it: "${bootstrap_token}

Ответ содержит токен доступа с максимальными правами, следует его сохранить.

Создать токен агента в consul:

agent_token=$(curl -s -X PUT -H "X-Consul-Token: ${bootstrap_token}" \

consul.${infra_domain}:8500/v1/acl/create \

-d '{"Name": "Agent Token",

"Type": "client",

"Rules":"node \"\" { policy = \"write\" } service \"\" { policy = \"read\" }"}' \

| jq -r '.ID')

Применить токен агента в consul:

curl -X PUT -H "X-Consul-Token: ${bootstrap_token}" \

consul.${infra_domain}:8500/v1/agent/token/acl_agent_token \

-d '{ "Token": "'${agent_token}'" }'

Выполнить проверку:

- Состояние запуска контейнера

kubectl get po -n ${infra_namespace} consul-0 -o wide -w - Логи контейнера

kubectl logs -n ${infra_namespace} consul-0 -f - Возможность подключения с авторизационными данными

Для наполнения authfile выставить значения:

- consul.host:

"consul.in.monq.local"; - consul.port:

8500; - consul.proto:

http; - consul.users.root_user.token:

"<check ${bootstrap_token}>";

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

СУБД, кеш и диспетчер сообщений

Общие положения:

- В данном документе рассматривается решение по запуску всех компонентов внутри kubernetes;

- В случае требуется запустить компонент СПО другим методом, рекомендуем воспользоваться официальной инструкцией поставщика решения. Настройку необходимо будет произвести как managed сервис;

- В предложенных примерах в качестве хранилища данных для компонентов СУБД используется локальный каталог (hostPath volume) на ноде. Этот способ указан для примера, что бы программный комплекс можно было запустить вне зависимости от наличия того или иного хранилища, а следуя пошаговой инструкции. Не рекомендуется использовать данный тип хранилища для промышленной эксплуатации. В случае если СПО будет запущено в kubernetes в продуктивном режиме, рекомендуется подключать хранилища в рекомендуемой конфигурации: см документацию kubernetes;

- В данном документе не рассматриваются лучшие практики по запуску кластерных решений.

- Для установки большинства компонентов требуются установленные Helm и Crane см. Установка пакетов;

- В примере будет рассмотрена установка компонентов без резервирования;

- Методы запуска HA и managed решений отражены в приложениях.

Выбор оптимального решения всегда обусловлен требованиями к отказоустойчивости и производительности конкретной инсталляции. Данное руководство демонстрирует базовый подход к запуску кластера высокой доступности и настройку Monq для работы с ним. В целях минимизации ручной настройки используются операторы k8s от производителя СПО.

Инструкция составлена с учетом выполнения команд от пользователя root, поэтому перед выполнением команд необходимо

перейти на использование root и установить переменные:

su -

infra_domain=in.monq.local

registry_address=registry.${infra_domain}:5000

infra_namespace=infra

monq_namespace=production

PostgreSQL

Дополнительные варианты развертывания:

- Приложение. HA PostgreSQL.

- Приложение. Managed services, раздел PostgreSQL.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста postgres вида postgresql.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен postgres(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} postgresql=

Выполнить запуск с помощью helm chart:

helm install postgresql offline/charts/postgresql-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Получить автоматически сгенерированный пароль пользователя postgres:

postgres_password=$(kubectl get secrets -n ${infra_namespace} postgresql-secret \

-o jsonpath='{.data.POSTGRES_PASSWORD}' | base64 --decode)

echo "save it: ${postgres_password}"

Выполнить проверку:

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} postgresql-0 -o wide - Логи контейнера:

kubectl logs -n ${infra_namespace} postgresql-0 -f - Выполнить запуск временного pod для выполнения проверки.

kubectl run utils -n ${monq_namespace} \

--image="${registry_address}/utils:3.3" -- \

/bin/bash -c -- "trap : TERM INT; sleep infinity & wait" - Возможность подключения с авторизационными данными.

kubectl exec -it -n ${monq_namespace} utils \

-- psql -c "SHOW server_version;" \

postgresql://postgres:${postgres_password}@postgresql.${infra_domain}

kubectl delete pod -n ${monq_namespace} utils

Для наполнения authfile выставить значения:

- postgresql.host:

"postgresql.in.monq.local"; - postgresql.port:

5432; - postgresql.ssl:

false; - postgresql.ssl_mode:

"Require"; - postgresql.ssl_trust:

true; - postgresql.users.root_user.name:

"postgres"; - postgresql.users.root_user.password:

"< check ${postgres_password}" >.

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

RabbitMQ

Дополнительные варианты развертывания:

- Приложение. HA RabbitMQ.

- Приложение. Managed services, раздел RabbitMQ.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста consul вида rabbitmq.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен rabbitmq(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} rabbitmq=

Выполнить запуск с помощью helm chart:

helm install rabbitmq offline/charts/rabbitmq-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Выполнить проверку:

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} rabbitmq-0 -o wide - Логи контейнера:

kubectl logs -n ${infra_namespace} rabbitmq-0 -f

Создать пользователя с административными правами:

rabbitmq_root_password=$(openssl rand -base64 16)

echo "save it: "${rabbitmq_root_password}

curl -X PUT http://guest:guest@rabbitmq.${infra_domain}:15672/api/users/root \

-d '{"password": "'${rabbitmq_root_password}'", "tags":"administrator"}'

curl -X PUT http://guest:guest@rabbitmq.${infra_domain}:15672/api/permissions/%2F/root \

-d '{"configure":".*","write":".*","read":".*"}'

curl -X DELETE --user root:${rabbitmq_root_password} \

http://rabbitmq.${infra_domain}:15672/api/users/guest

Для наполнения authfile выставить значения:

- rabbitmq.host:

"rabbitmq.in.monq.local"; - rabbitmq.port:

15672; - rabbitmq.amqp_port:

5672; - rabbitmq.amqp_ssl:

false; - rabbitmq.proto:

"http"; - rabbitmq.virtual_host:

"/"; - rabbitmq.quorum_queues:

false; - rabbitmq.users.root_user.name:

"root"; - rabbitmq.users.root_user.password:

"<check ${rabbitmq_root_password}>".

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

Arangodb

Дополнительные варианты развертывания:

- Приложение. HA Arangodb.

- Приложение. Managed services, раздел Arangodb.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста postgres вида arangodb.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен arangodb(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} arangodb=

Выполнить запуск с помощью helm chart:

helm install arangodb offline/charts/arangodb-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Получить автоматически сгенерированный пароль пользователя root:

arangodb_password=$(kubectl get secrets -n ${infra_namespace} arangodb-secret \

-o jsonpath='{.data.ARANGO_ROOT_PASSWORD}' | base64 --decode)

echo "save it: ${arangodb_password}"

Выполнить проверку:

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} arangodb-0 -o wide -w - Логи контейнера:

kubectl logs -n ${infra_namespace} arangodb-0 -f - Выполнить запуск временного pod для выполнения проверки.

kubectl run utils -n ${monq_namespace} \

--image="${registry_address}/utils:3.3" -- \

/bin/bash -c -- "trap : TERM INT; sleep infinity & wait" - Возможность подключения с авторизационными данными.

kubectl exec -it -n ${monq_namespace} utils \

-- curl -X POST -u root:${arangodb_password} \

arangodb.${infra_domain}:8529/_db/_system/_admin/echo \

-d "string" | jq

kubectl delete pod -n ${monq_namespace} utils

Для наполнения authfile выставить значения:

- arangodb.host:

"arangodb.in.monq.local"; - arangodb.port:

8529; - arangodb.proto:

"http"; - arangodb.users.root_user.name:

"root"; - arangodb.users.root_user.password:

"< check ${arangodb_password} >".

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

Clickhouse

Дополнительные варианты развертывания:

- Приложение. HA Clickhouse.

- Приложение. Managed services, раздел Clickhouse.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста postgres вида clickhouse.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен clickhouse(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} clickhouse=

Выполнить запуск с помощью helm chart:

helm install clickhouse offline/charts/clickhouse-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Получить автоматически сгенерированный пароль пользователя admin:

clickhouse_password=$(kubectl get secrets -n ${infra_namespace} clickhouse-secret \

-o jsonpath='{.data.CLICKHOUSE_ADMIN_PASSWORD}' | base64 --decode)

echo "save it: ${clickhouse_password}"

Выполнить проверку:

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} clickhouse-0 -o wide - Логи контейнера:

kubectl logs -n ${infra_namespace} clickhouse-0 -f - Выполнить запуск временного pod для выполнения проверки.

kubectl run utils -n ${monq_namespace} \

--image="${registry_address}/utils:3.3" -- \

/bin/bash -c -- "trap : TERM INT; sleep infinity & wait" - Возможность подключения с авторизационными данными:

kubectl exec -it -n ${monq_namespace} utils \

-- curl --get --data-urlencode "query=SELECT version()" \

-u root_user:${clickhouse_password} clickhouse.${infra_domain}:8123

kubectl delete pod -n ${monq_namespace} utils

Для наполнения authfile выставить значения:

- clickhouse.host:

"clickhouse.in.monq.local"; - clickhouse.port:

8123; - clickhouse.proto:

"http"; - clickhouse.cluster:

false; - clickhouse.cluster_name:

"monq"; - clickhouse.users.root_user.name:

"root_user"; - clickhouse.users.root_user.password:

"<check ${clickhouse_password}>".

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

Redis

Дополнительные варианты развертывания:

- Приложение. HA Redis.

- Приложение. Managed services, раздел Redis.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста postgres вида redis.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен redis(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} redis=

Выполнить запуск с помощью helm chart:

helm install redis offline/charts/redis-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Получить автоматически сгенерированный пароль пользователя default:

redis_password=$(kubectl get secrets -n ${infra_namespace} redis-secret \

-o jsonpath='{.data.REDIS_PASSWORD}' | base64 --decode)

echo "save it: ${redis_password}"

Выполнить проверку:

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} redis-0 -o wide - Логи контейнера:

kubectl logs -n ${infra_namespace} redis-0 -f - Выполнить запуск временного pod для выполнения проверки.

kubectl run utils -n ${monq_namespace} \

--image="${registry_address}/utils:3.3" -- \

/bin/bash -c -- "trap : TERM INT; sleep infinity & wait" - Возможность подключения с авторизационными данными:

kubectl exec -it -n ${monq_namespace} utils \

-- redis-cli -h redis.${infra_domain} -a "${redis_password}" PING

kubectl delete pod -n ${monq_namespace} utils

Для наполнения authfile выставить значения:

- redis.host:

"redis.in.monq.local"; - redis.port:

6379; - redis.ssl:

false; - redis.sentinel:

false; - redis.service_name:

"mymaster"; - redis.users.root_user.password:

"<check ${redis_password}">.

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

VictoriaMetrics

Дополнительные варианты развертывания:

- Приложение. HA VictoriaMetrics.

- Приложение. Managed services, раздел Victoria metrics.

Перед началом работ необходимо создать на внешнем DNS сервере запись для хоста postgres вида victoriametrics.${infra_domain},

запись должна разрешаться в IP сервера на котором расположен victoriametrics(в данном примере сервер db).

Внимание! Команды выполняются на сервере master.

Выполнить назначение метки на выбранную ноду:

server_name="db"

kubectl label no ${server_name} victoriametrics=

Выполнить запуск с помощью helm chart:

helm install victoriametrics offline/charts/victoriametrics-1.1.0.tgz \

--namespace ${infra_namespace} --create-namespace \

--set application.image.registry=${registry_address} \

--set application.ssl.enable=false

Устройство чарта описано в соответствующем приложении, см. Приложение. Описание типового helm chart.

Получить автоматически сгенерированный пароль пользователя monq:

vm_password=$(kubectl get secrets -n ${infra_namespace} victoriametrics-secret \

-o jsonpath='{.data.VM_AUTH_PASSWORD}' | base64 --decode)

echo "save it: ${vm_password}"

Выполнить проверку

- Состояние запуска контейнера:

kubectl get po -n ${infra_namespace} victoriametrics-0 -o wide - Логи контейнера:

kubectl logs -n ${infra_namespace} victoriametrics-0 -f - Выполнить запуск временного pod для выполнения проверки.

kubectl run utils -n ${monq_namespace} \

--image="${registry_address}/utils:3.3" -- \

/bin/bash -c -- "trap : TERM INT; sleep infinity & wait" - Возможность подключения с авторизационными данными.

kubectl exec -it -n ${monq_namespace} utils \

-- curl -u monq:${vm_password} \

victoriametrics.${infra_domain}:8428/prometheus/api/v1/status/tsdb

kubectl delete pod -n ${monq_namespace} utils

Для наполнения authfile выставить значения:

- victoriametrics.host:

"victoriametrics.in.monq.local"; - victoriametrics.port:

8428; - victoriametrics.proto:

"http"; - victoriametrics.auth_type:

"BasicAuth"; - victoriametrics.users.root_user.name:

"monq"; - victoriametrics.users.root_user.password:

"<check ${vm_password}">.

Внимание! Значение вышеуказанных переменных заполнены с учетом текущего примера.

Заключение

Результатом выполнения инструкций предыдущих разделов можно считать:

- Рабочую инфраструктуру для запуска Monq;

- Заполненный authfile(

system_auth.json), содержащий настройки для подключения ко всем компонентам СПО.

Перед переходом к дальнейшей установке необходимо убедиться что все данные внесены, в случае отсутствия какого либо из блоков, заполнить данные

Установка Monq

Установка выполняется с помощью сценария поставляемого в виде контейнера, содержащего все необходимые библиотеки и зависимости.

В поставке Monq идет два сценария:

- Сценарий установки Monq;

- Сценарий очистки СПО от объектов Monq.

Список переменных, используемых по тексту:

${global_domain}- основное доменное имя развертываемого приложения${registry_address}- адрес репозитория контейнеров, если используется развернутый по данной инструкции, то http://registry.in.monq.local:5000

Подготовка к установке

- Подготовить файл авторизации СПО

system_auth.json; - Проверить, что точки подключения к компонентам СПО доступны с той машины, где будет запущена установка;

- Выбрать доменное имя для установки Monq, далее будет обозначено как

${global_domain}; - Обеспечить разрешение доменных имен

${global_domain},api.${global_domain},registry.api.${global_domain}в адрес ingress-controller, установленный в kubernetes. Указанные доменные имена должны корректно резолвиться внутри kubernetes и с машины на которой будет производиться запуск сценария;

Запуск сценария установки

В примерах запуска сценариев установки используется минимальный набор переменных, с полным списком переменных можно ознакомится в соответствующем документе, см. Приложение. Список изменяемых переменных сценария установщика.

В данном примере рассматривается запуск установки с помощью контейнера, запущенного вне кластера kubernetes, для запуска установки внутри кластера kubernetes, см. Приложение. Установка внутри кластера kubernetes.

Сценарий установки запускается за пределами инфраструктуры развертываемой системы, например с машины системного администратора. Настроен вышестоящий DNS, все требуемые доменные имена из раздела (Подготовка системного программного обеспечения) корректно разрешаются в IP адреса соответствующих сервисов.

Создать каталог для артефактов установки, разместить в данном каталоге authfile.

installer_files="< каталог с артефактами установщика и файлом авторизации СПО, по умолчанию /opt/monq >"

mkdir -p ${installer_files}

cp `authfile` ${installer_files}/system_auth.json

Запустить контейнер со сценарием установки:

installer_files="< каталог с артефактами установщика и файлом авторизации СПО, по умолчанию /opt/monq >"

global_domain="<доменное имя>"

registry_address="<адрес репозитория контейнеров>"

crictl pull ${registry_address}/installer:8.9.0

ctr -n k8s.io run --rm --net-host \

--mount type=bind,src=${installer_files},dst=/opt/monq,options=rbind:rw \

${registry_address}/installer:8.9.0 monq-installer-temp \

ansible-playbook -e "global_domain='${global_domain}'"\

monq/monq.yaml

В случае возникновения ошибок они будут отражены в файле errors.json, расположенном в каталоге ${installer_files}.

После установки система готова к использованию, интерфейс доступен по адресу ${global_domain}.

Авторизационные данные по-умолчанию:

- логин:

admin@${global_domain} - пароль:

monq_admin

Запуск сценария удаления

В случае, если установка не была завершена успешно, следует использовать сценарий eraser, с помощью него очищаются

все компоненты СПО от объектов Monq.

Внимание! Удаление должно запускаться с теми же переменными, что и установка

Запустить контейнер со сценарием удаления:

installer_files="< каталог с артефактами установщика и файлом авторизации СПО, по умолчанию /opt/monq >"

ctr -n k8s.io run --rm --net-host \

--mount type=bind,src=${installer_files},dst=/opt/monq,options=rbind:rw \

${registry_address}/installer:8.9.0 monq-installer-temp \

ansible-playbook -e "global_domain='${global_domain}'"\

monq/eraser.yaml

Приложение. Инструкция по наполнению authfile

Authfile используется сценарием установки Monq для подключения к инфраструктурным объектам и создания объектов Monq:

- Манифесты kubernetes;

- Пользователи и базы данных;

- Прочие объекты требуемые для работы Monq.

В authfile помимо параметров подключения, указывается тип запуска системного программного обеспечения, это может быть cluster(ha) или standalone, и соответствующие ключи для конфигурации параметров.

Внимание! Важно корректно заполнить параметры подключения к СПО, т.к. для некоторых компонентов взаимодействие с HA СПО отличается от режима standAlone.

В приложенных документах хранится модель данных authfile и описание переменных, необходимо внимательно изучить эти документы перед наполнением.

Описание полей файла авторизации в компонентах СПО

| Ключ | Тип | Описание |

|---|---|---|

| arangodb.host | string | hostname или ip адрес сервера arangodb |

| arangodb.port | int | порт сервера сервера arangodb |

| arangodb.proto | string | протокол сервера сервера arangodb (http,https) |

| arangodb.users.root_user.name | string | имя пользователя arangodb |

| arangodb.users.root_user.password | string | пароль пользователя arangodb |

| clickhouse.host | string | hostname или ip адрес сервера clickhouse |

| clickhouse.port | int | порт сервера clickhouse |

| clickhouse.proto | string | протокол сервера clickhouse (http,https) |

| clickhouse.cluster | bool | Переменная должна быть true если используется |

| cluster режим | ||

| clickhouse.cluster_name | string | Имя кластера в clickhouse. Если не используется |

кластер - задать любое значение, например monq | ||

| clickhouse.users.root_user.name | string | имя пользователя clickhouse |

| clickhouse.users.root_user.password | string | пароль пользователя clickhouse |

| consul.host | string | hostname или ip адрес consul |

| consul.port | int | порт consul |

| consul.proto | string | протокол consul (http,https) |

| consul.users.root_user.token | string | токен пользователя consul |

| k8s.host | string | hostname или ip адрес apiserver kubernetes |

| k8s.port | int | порт apiserver kubernetes |

| k8s.proto | string | протокол apiserver kubernetes (http,https) |

| k8s.users.root_user.token | string | токен авторизации в apiserver kubernetes |

| postgresql.host | string | hostname или ip адрес сервера postgresql |

| postgresql.port | int | порт сервера postgresql |

| postgresql.ssl | bool | используется ли ssl для подключению к серверу |

| postgresql | ||

| postgresql.ssl_mode | string | Режим ssl для подключению к серверу postgresql. |

| Переменная должна быть задана если используется | ||

ssl. Возможные значения: Allow, Prefer, Require. | ||

| Если ssl не используется, указать любое из значений | ||

| postgresql.ssl_trust | bool | Доверять ssl сертификату сервера postgresql. Если ssl |

не используется, указать false | ||

| postgresql.users.root_user.name | string | имя пользователя postgresql |

| postgresql.users.root_user.password | string | пароль пользователя postgresql |

| rabbitmq.host | string | hostname или ip адрес сервера rabbitmq |

| rabbitmq.port | int | порт сервера rabbitmq |

| rabbitmq.amqp_port | int | ampq порт сервера rabbitmq |

| rabbitmq.amqp_ssl | bool | использовать ssl для amqp |

| rabbitmq.proto | string | протокол api сервера rabbitmq (http,https) |

| rabbitmq.quorum_queues | bool | использовать ли quorum очереди, необходимо |

| для кластера | ||

| rabbitmq.virtual_host | string | vhost в rabbitmq, задать / если не используется |

| кастомный | ||

| rabbitmq.users.root_user.name | string | имя пользователя rabbitmq |

| rabbitmq.users.root_user.password | string | пароль пользователя rabbitmq |

| redis.host | string | hostname или ip адрес сервера redis |

| redis.port | int | порт сервера redis |

| redis.ssl | bool | использовать ssl для redis |

| redis.ssl_host | bool | опционально, CN в сертификате redis |

| redis.sentinel | bool | используется ли sentinel |

| redis.service_name | string | имя сервиса в sentinel. Должна быть задана если |

| используется sentinel. Если не используется, | ||

то задать mymaster | ||

| redis.users.root_user.name | string | имя пользователя redis, если включен ACL |

| redis.users.root_user.password | string | пароль пользователя redis |

| registry.host | string | hostname или ip адрес имя пользователя |

| registry.port | int | порт docker registry |

| registry.proto | string | протокол docker registry (http,https) |

| registry.auth_type | string | тип авторизации в docker registry |

(None, BasicAuth, Token) | ||

| registry.location | string | путь в registry до образов Monq (например |

если переменная задана и имеет значение monq | ||

| при деплое image будет запрошен по | ||

myregistry.ru/monq/myservice:mytag) | ||

| registry.user | string | опционально. имя пользователя docker registry |

| registry.password | string | опционально. пароль пользователя docker registry |

| victoriametrics.host | string | hostname или ip адрес сервера victoria metrics. |

| Должен быть задан если cluster = false | ||

| victoriametrics.port | int | порт сервера victoria metrics. Должен быть задан |

| если cluster = false | ||

| victoriametrics.proto | string | протокол сервера victoria metrics (http,https). |

| Должен быть задан если cluster = false | ||

| victoriametrics.cluster | bool | используется ли кластер victoria metrics |

| victoriametrics.cluster_account | string | аккаунт в кластере victoria metrics. Должен быть |

| задан если используется кластерная версия | ||

| victoriametrics.auth_type | string | тип авторизации в victoria metrics, возможные |

значения BasicAuth,None | ||

| victoriametrics.cluster_insert.host | string | hostname или ip адрес сервера vminsert. Должен |

| быть задан если используется кластерная версия | ||

| victoriametrics.cluster_insert.port | int | опционально. порт сервера vminsert. Должен |

| быть задан если используется кластерная версия | ||

| victoriametrics.cluster_insert.proto | string | опционально. протокол сервера vminsert |

(http,https). Должен быть задан если | ||

| используется кластерная версия | ||

| victoriametrics.cluster_select.host | string | опционально. hostname или ip адрес сервера |

| select. Должен быть задан если используется | ||

| кластерная версия | ||

| victoriametrics.cluster_select.port | string | порт сервера vmselect. Должен быть задан |

| если используется кластерная версия | ||

| victoriametrics.cluster_select.proto | string | протокол сервера vmselect (http,https). Должен |

| быть задан если используется кластерная версия | ||

| victoriametrics.users.root_user.name | int | имя пользователя victoria metrics, должен быть |

задан если auth_type = BasicAuth | ||

| victoriametrics.users.root_user.password | string | пароль пользователя victoria metrics, должен |

быть задан если auth_type = BasicAuth |

Пример файла system_auth.json

{

"arangodb":{"host":"arangodb.in.monq.local","port":8529,"proto":"http",

"users":{"root_user":{"name":"root","password":"**********"}}

},

"clickhouse":{"host":"clickhouse.in.monq.local","port":8123,"proto":"http",

"cluster":false,"cluster_name":"monq",

"users":{"root_user":{"name":"root_user","password":"*********"}}

},

"consul":{"host":"consul.in.monq.local","port":8500,"proto":"http",

"users":{"root_user":{"token":"**********"}}

},

"k8s":{"host":"k8s-api.in.monq.local","port":6443, "proto": "https",

"users":{"root_user":{"token":"***********"}}

},

"postgresql":{"host":"postgresql.in.monq.local","port":5432,"ssl":false,

"ssl_mode":"Require","ssl_trust":true,

"users":{"root_user":{"name":"postgres","password":"********"}}

},

"rabbitmq":{"amqp_port":5672,"host":"rabbitmq.in.monq.local","port":15672,

"proto":"http","amqp_ssl":false,"quorum_queues":false,"virtual_host":"/",

"users":{"root_user":{"name":"root","password":"*********"}}

},

"redis":{"host":"redis.in.monq.local","port":6379,"ssl":false,"sentinel":false,

"service_name":"mymaster",

"users":{"root_user":{"password":"********"}}

},

"registry":{"host":"registry.in.monq.local","port":5000,"proto":"https",

"auth_type":"None","user":"registry","password":"********"

},

"victoriametrics":{"host":"victoriametrics.in.monq.local","port":8428,"proto":"http",

"cluster":false,"cluster_account":"0","auth_type":"BasicAuth",

"cluster_insert":{"host":"vminsert.in.monq.local","port":8480,"proto":"http"},

"cluster_select":{"host":"vmselect.in.monq.local","port":8481,"proto":"http"},

"users":{"root_user":{"name":"monq","password":"******"}}

}

}

Приложение. Kubernetes режим MultiMaster

Внимание! Перед началом работ по данной главе предварительно должны быть установлены необходимые пакеты, см. Установка пакетов

Продуктивная среда, рекомендуется для установок с высокими требованиями по отказоустойчивости.

Необходимо обязательно создать на внешнем DNS сервере запись для хоста apiserver вида k8s-api.${infra_domain},

на первоначальном этапе запись должна разрешаться в IP первого master сервера.

Внимание! Команды выполняются на всех серверах master.

Задать нужное имя сервера, в примере используется master-<n>, где <n> - порядковый номер сервера:

hostnamectl set-hostname master-<n>

Выполнить настройку синхронизации времени, и убедиться что время синхронизировано:

timedatectl status

В случае если необходимо изменить адреса NTP серверов надо отредактировать файл и выполнить перезапуск сервиса:

nano /etc/systemd/timesyncd.conf

systemctl enable systemd-timesyncd

systemctl restart systemd-timesyncd

Отключить swap:

swapoff -a

sed -i '/ swap / s/^/#/' /etc/fstab

Загрузить необходимые модули ядра:

cat <<EOF | tee /etc/modules-load.d/containerd.conf

overlay

br_netfilter

EOF

modprobe br_netfilter

modprobe overlay

Добавить опции ядра:

cat <<EOF | tee /etc/sysctl.d/99-kubernetes-cri.conf

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

fs.inotify.max_user_instances = 524288

EOF

cat <<EOF | tee /etc/sysctl.d/70-disable-ipv6.conf

net.ipv6.conf.all.disable_ipv6 = 1

EOF

sysctl --system

Выполнить конфигурацию containerd:

containerd config default | sed "

s|SystemdCgroup = false|SystemdCgroup = true|g

s|\(.*sandbox_image = \)\".*/pause:.*\"|\1\"${registry_address}/pause:3.10\"|g

" > /etc/containerd/config.toml

systemctl enable containerd